Come funzionano i modelli linguistici di grandi dimensioni

Prima del deep learning, i computer elaboravano il linguaggio utilizzando regole codificate a mano e modelli statistici come n-grammi.

Questi primi sistemi non erano in grado di cogliere le sfumature del linguaggio umano e non riuscivano a generalizzare.

La svolta è arrivata con incorporamenti di parole, un modo per rappresentare le parole come vettori densi in uno spazio continuo.

Questo ha segnato l'inizio delle macchine didattiche: significato di parole attraverso modelli nei dati.

Di seguito sono riportate le principali pietre miliari che hanno aperto la strada agli LLM che utilizziamo oggi.

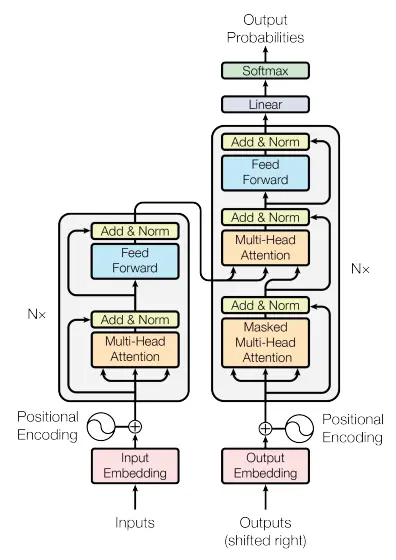

L'architettura Transformer, introdotta nel documento del 2017 «L'attenzione è tutto ciò di cui hai bisogno» è il fondamento di quasi tutti i moderni modelli linguistici di grandi dimensioni, tra cui GPT, Claude, LLama, Gemini e Mistral.

A differenza delle reti neurali ricorrenti (RNN), i trasformatori elaborano intere sequenze contemporaneamente utilizzando attenzione personale, che consente a ciascun token di decidere quanta attenzione dedicare agli altri.

In altre parole, ha sostituito l'elaborazione sequenziale con attenzione personale, consentendo ai modelli di elaborare intere sequenze in parallelo e di modellare le dipendenze a lungo raggio in modo più efficace rispetto alle reti neurali ricorrenti (RNN).

Ma cosa fa funzionare esattamente un Transformer?

Analizziamo il suo componenti principali, ognuno dei quali svolge un ruolo cruciale nel modo in cui questi modelli codificano, gestiscono e trasformano il testo.

Questo video è un ottimo compagno per «L'attenzione è tutto ciò di cui hai bisogno« articolo di Vaswani et al. (2017).

Visualizza l'architettura e il funzionamento interno del Transformer in un modo accessibile a un pubblico tecnico e non tecnico, evidenziando le idee chiave.

I modelli linguistici non comprendono il testo come gli umani.

Prevedono il molto probabilmente il prossimo token basato su tutto ciò che è stato visto prima, utilizzando distribuzioni di probabilità sul vocabolario.

[«Il», «cane», «abbaia»], quindi mappato agli ID dei token.

L'addestramento di un modello linguistico di grandi dimensioni implica l'esposizione a vasti set di dati di testo e l'insegnamento a prevedere i token.

Questo processo può richiedere settimane supercomputer con migliaia di GPU.

L'addestramento di un modello linguistico di grandi dimensioni implica l'esposizione a enormi set di dati di testo e l'insegnamento a prevedere i token, un processo che può richiedere settimane su supercomputer AI con oltre 10.000 GPU, consumando centinaia di ZettaFLOPS di calcolo e determinazione dei costi decine di milioni di dollari.

Uno ZettaFlop, abbreviazione di zetta floating-point operations per second, è un'unità di potenza computazionale pari a 10²¹ operazioni al secondo (ovvero 1 sestilione, o un 1 seguito da 21 zeri). Sebbene le prestazioni su scala ZettaFLOP rimangano in gran parte teoriche per attività prolungate, sono un modo utile per esprimere il calcolo cumulativo totale richiesto per addestrare i modelli di intelligenza artificiale più avanzati di oggi.

Dopo il pretraining, i modelli linguistici di grandi dimensioni possono essere messo a punto per svolgere meglio compiti specifici o allinearsi più da vicino alle aspettative umane. Questo passaggio è facoltativo ma ampiamente utilizzato per rendere i modelli più utili nelle applicazioni del mondo reale.

La messa a punto consente al modello di:

Questo è l'approccio più comune. Il modello è addestrato su esempi in cui gli input sono abbinati a risposte desiderate di alta qualità. Nel tempo, impara a generalizzare e seguire istruzioni simili anche se non facevano parte della formazione.

Uno dei più potenti tecniche di messa a punto. Migliora l'allineamento grazie al feedback dei valutatori umani:

Questo metodo è stato utilizzato in Instruire GPT, uno dei primi modelli allineati (Ouyang e al., 2022), e successivamente ampliato da Antropico con IA costituzionale, che insegna ai modelli a criticare e rivedere le proprie risposte sulla base di linee guida etiche predefinite (Bai et al., 2022).

Nonostante scrivano saggi, spieghino barzellette o scrivano codice, gli LLM in realtà non «capiscono» nulla.

Non formano convinzioni né possiedono intenzioni.

Sono motori probabilistici addestrato a continuare le sequenze di testo in modi plausibili.

Simulano l'intelligenza mediante:

«La formazione di modelli linguistici sempre più ampi senza affrontare le limitazioni sottostanti rischia di creare sistemi che sembrano autorevoli ma privi di responsabilità o fondamento fattuale». 📚 Pappagalli stocastici: Bender et al., 2021

I modelli linguistici di nuova generazione si stanno evolvendo rapidamente, non solo in scala, ma anche potenziale.

Questi modelli stanno diventando:

Man mano che i modelli linguistici si evolvono in sistemi più capaci e autonomi, diversi paradigmi fondamentali stanno plasmando il loro futuro.

3 idee fondamentali:

🧠 Miscela di esperti (MoE)

Suggerimento: leggi Shazeer e altri, 2017

I modelli MoE migliorano l'efficienza attivando solo un piccolo sottoinsieme dei loro parametri per ogni ingresso, rendendo possibile la scalabilità senza aumentare proporzionalmente il calcolo.

🧩 Ragionamento sulla catena di pensiero

Suggerimento: leggi Wei et al., 2022

Questa strategia di stimolo incoraggia i modelli a pensare passo dopo passo, migliorando significativamente le prestazioni su compiti complessi di ragionamento e matematica.

🔍 Generazione aumentata di recupero (RAG)

Suggerimento: esplora il Guida Cohere RAG

RAG combina modelli linguistici con fonti di conoscenza esterne, consentendo loro di estrarre informazioni pertinenti da database o documenti prima di generare risposte.

Queste tecniche sono gli elementi costitutivi dei sistemi di intelligenza artificiale di nuova generazione.

Inizia con questi documenti per vedere dove sta andando il futuro.

I Large Language Models rappresentano un cambiamento epocale nell'interazione uomo-computer.

Sono motori probabilistici di sintesi della conoscenza.

Se i motori di ricerca riguardavano le parole chiave, gli LLM riguardano contesto, chiarezzae citazioni.

RAG (Generazione aumentata di recupero) è una tecnica di intelligenza artificiale all'avanguardia che migliora i modelli linguistici tradizionali integrando un sistema esterno di ricerca o recupero delle conoscenze. Invece di affidarsi esclusivamente a dati preaddestrati, un modello abilitato al RAG può ricerca in un database o in una fonte di conoscenza in tempo reale e utilizza i risultati per generare risposte più accurate e contestualmente pertinenti.

Per GEO, questo è un punto di svolta.

GEO non risponde solo con un linguaggio generico, ma recupera informazioni fresche e pertinenti dalla knowledge base, dai documenti o dai contenuti web esterni della tua azienda prima di generare la risposta. Ciò significa:

Combinando i punti di forza della generazione e recupero, RAG assicura che GEO non si limita suono intelligente—esso è intelligente, in linea con la tua fonte di verità.

Modelli linguistici di grandi dimensioni (LLM) come GPT vengono addestrati su grandi quantità di dati di testo per apprendere i modelli, le strutture e le relazioni tra le parole. Essenzialmente, predire la parola successiva in una sequenza basato su ciò che è venuto prima, consentendo loro di generare un linguaggio coerente e simile a quello umano.

Questo è importante per GEO (ottimizzazione generativa del motore) perché significa che i tuoi contenuti devono essere:

Comprendendo come «pensano» gli LLM, le aziende possono ottimizza i contenuti non solo per gli esseri umani o i motori di ricerca, ma per i modelli di intelligenza artificiale che stanno diventando il nuovo livello di scoperta.

Conclusione: Se i tuoi contenuti aiutano il modello a prevedere la risposta giusta, GEO aiuta gli utenti a trovare voi.

Tokenizzazione è il processo mediante il quale i modelli di intelligenza artificiale, come GPT, suddividono il testo in piccole unità, chiamato gettoni—prima dell'elaborazione. Questi token possono essere piccoli come un singolo carattere o grandi come una parola o una frase. Ad esempio, la parola «commercializzazione» potrebbe essere un token, mentre «Strumenti basati sull'intelligenza artificiale» potrebbe essere suddiviso in più parti.

Perché è importante per GEO (ottimizzazione generativa del motore)?

Perché il grado di tokenizzazione dei tuoi contenuti influisce direttamente sulla precisione con cui vengono compresi e recuperati dall'intelligenza artificiale. Una scrittura mal strutturata o eccessivamente complessa può confondere i confini dei token, con conseguente mancanza di contesto o risposte errate.

✅ Linguaggio chiaro e conciso = migliore tokenizzazione

✅ Titoli, elenchi e dati strutturati = più facili da analizzare

✅ Terminologia coerente = migliore richiamo dell'IA

In breve, ottimizzare per GEO significa scrivere non solo per i lettori o i motori di ricerca, ma anche per come funziona l'IA tokenizza e interpreta i tuoi contenuti dietro le quinte.

I Large Language Model (LLM) sono sistemi di intelligenza artificiale addestrati su enormi quantità di dati di testo, dai siti Web ai libri, per comprendere e generare il linguaggio.

Usano algoritmi di deep learning, in particolare architetture di trasformatori, per modellare la struttura e il significato del linguaggio.

Gli LLM non «conoscono» i fatti come fanno gli umani. Invece, prevedono la parola successiva in una sequenza utilizzando le probabilità, in base al contesto di tutto ciò che l'ha preceduta. Questa capacità consente loro di produrre risposte fluenti e pertinenti su innumerevoli argomenti.

Per uno sguardo più approfondito alla meccanica, dai un'occhiata al nostro post completo sul blog: Come funzionano i modelli linguistici di grandi dimensioni.

L'addestramento di un modello linguistico di grandi dimensioni implica l'alimentazione di enormi volumi di dati di testo, da libri e blog a documenti accademici e contenuti web.

Questi dati sono tokenizzato (suddiviso in parti più piccole come parole o sottoparole) e quindi elaborato attraverso più livelli di un modello di deep learning.

Nel tempo, il modello impara relazioni statistiche tra parole e frasi. Ad esempio, apprende che «caffè» appare spesso vicino a «mattina» o «caffeina». Queste associazioni aiutano il modello a generare un testo intuitivo e umano.

Una volta terminato l'addestramento di base, i modelli sono spesso messo a punto utilizzando dati aggiuntivi e feedback umano per migliorare la precisione, il tono e l'utilità. Il risultato: uno strumento potente che comprende il linguaggio abbastanza bene da assisterti in tutto, dall'ottimizzazione SEO alla conversazione naturale.

Le trasformatore è l'architettura fondamentale alla base dei moderni LLM come GPT. Introdotti in un innovativo documento di ricerca del 2017, i trasformatori hanno rivoluzionato l'elaborazione del linguaggio naturale consentendo ai modelli di considerare l'intero contesto di una frase contemporaneamente, piuttosto che semplici sequenze parola per parola.

L'innovazione chiave è meccanismo di attenzione, che aiuta il modello a decidere quali parole di una frase sono più pertinenti l'una per l'altra, imitando essenzialmente il modo in cui gli umani prestano attenzione a dettagli specifici in una conversazione.

I trasformatori consentono agli LLM di generare risposte più coerenti, consapevoli del contesto e accurate.

Ecco perché oggi sono al centro della maggior parte dei modelli linguistici all'avanguardia.